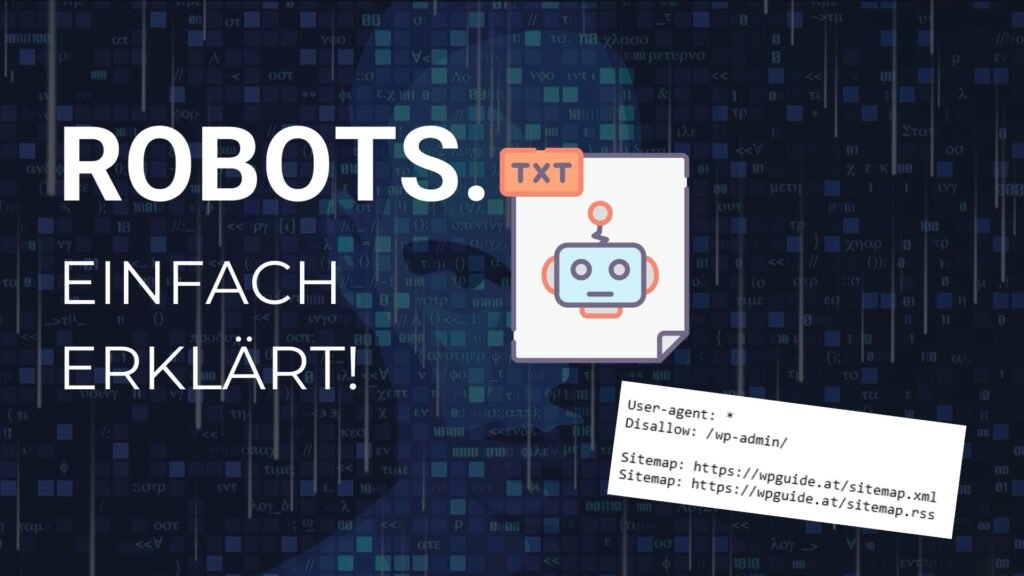

Was ist die Robots.txt-Datei?

Robots.txt-Dateien sind Textdateien, die auf Webservern platziert werden, um anzugeben, welche Seiten oder Verzeichnisse von Suchmaschinen-Robotern (auch bekannt als „Crawler“ oder „Bots“) durchsucht werden können und welche nicht.

Die Struktur der Robots.txt-Datei

Die Datei Robots.txt besteht aus verschiedenen Direktiven, die festlegen, wie Suchmaschinen-Crawler mit bestimmten Teilen einer Website umgehen sollen.

Diese Direktiven werden durch spezifische Anweisungen definiert, die den Zugriff auf bestimmte URLs oder Verzeichnisse steuern. Einige gängige Direktiven sind „User-agent„, „Disallow“ und „Allow„.

User-agent: Die „User-agent“-Direktive identifiziert den Suchmaschinen-Crawler, für den die folgenden Anweisungen gelten. Sie ermöglicht es Website-Betreibern, spezifische Anweisungen für verschiedene Suchmaschinen-Crawler festzulegen. Zum Beispiel kann die „User-agent: Googlebot“ Direktive verwendet werden, um Anweisungen nur für den Google-Crawler zu definieren.

Disallow: Die „Disallow“-Direktive gibt an, welche URLs oder Verzeichnisse für den angegebenen Crawler blockiert werden sollen. Wenn eine URL oder ein Verzeichnis in der Robots.txt-Datei mit „Disallow“ markiert ist, wird der Crawler daran gehindert, darauf zuzugreifen und sie zu indexieren.

Allow: Die „Allow“-Direktive erlaubt es Website-Betreibern, bestimmte URLs oder Verzeichnisse explizit für den Crawler freizugeben, auch wenn sie allgemein blockiert sind. Sie wird oft verwendet, um spezifische Seiten oder Inhalte freizugeben, die sonst blockiert wären.

Beispiel einer Robots.txt-Datei

User-agent: *

Disallow: /admin/

Allow: /public/

In diesem Beispiel werden alle Suchmaschinen-Crawler blockiert, den „/admin/“ Verzeichnisbereich zu durchsuchen, während der Zugriff auf den „/public/“ Bereich erlaubt ist.

Warum ist die Robots.txt-Datei wichtig?

Die Robots.txt-Datei spielt eine entscheidende Rolle für die Suchmaschinenoptimierung (SEO) einer Website aus mehreren Gründen:

- Schutz sensibler Informationen: Sie ermöglicht es Website-Betreibern, bestimmte Bereiche ihrer Website vor der Indexierung durch Suchmaschinen zu schützen, um sensible Informationen zu sichern.

- Steuerung der Indexierung: Sie gibt Website-Betreibern die Möglichkeit, die Indexierung ihrer Website zu steuern und sicherzustellen, dass nur relevante Inhalte in den Suchergebnissen erscheinen.

- Optimierung der Crawler-Effizienz: Durch die gezielte Blockierung von nicht-relevanten oder dynamisch generierten Seiten können Suchmaschinen-Crawler effizienter arbeiten und die Leistung der Website verbessern.

Wie optimiert man die Robots.txt-Datei für Suchmaschinen?

Grundlegende Blockierungen festlegen: Verwende die Robots.txt-Datei, um Suchmaschinenanweisungen zu geben, welche Teile deiner Website nicht durchsucht werden sollen. Zum Beispiel können Verzeichnisse wie der Admin-Bereich oder private Dateien blockiert werden.

Vermeide unnötige Blockaden: Stelle sicher, dass wichtige Teile deiner Website nicht versehentlich blockiert werden. Überprüfe regelmäßig deine Robots.txt-Datei, um sicherzustellen, dass sie korrekt konfiguriert ist und keine wichtigen Seiten ausschließt.

Optimierung für verschiedene Crawler: Berücksichtige die unterschiedlichen Anforderungen verschiedener Suchmaschinen-Crawler, wie zum Beispiel Googlebot oder Bingbot. Du kannst spezifische Anweisungen für jeden Crawler in deiner Robots.txt-Datei festlegen, um sicherzustellen, dass sie deine Website optimal durchsuchen.

Robots-Tags verwenden: Ergänze die Robots.txt-Anweisungen mit den Meta-Robots-Tags in deinen Seiten, um spezifische Anweisungen auf Seitenebene zu geben, wie z.B. „noindex“ oder „nofollow“.

Robots.txt-Dateien sind ein leistungsfähiges Instrument für Website-Besitzer, um die Indizierung ihrer Website zu kontrollieren und die SEO-Leistung zu optimieren. Durch die richtige Konfiguration und regelmäßige Aktualisierung kannst du sicherstellen, dass Suchmaschinen relevante Inhalte finden und die Website in den Suchergebnissen korrekt angezeigt wird.